Deep Learning 딥러닝 기본 이해

| Layer Level | Model Level |

| Manifold Learning(매니폴드 학습) | Representation Learning(표현 학습) |

| Transfer Learning(전이 학습) | Meta Learning(메타 학습) |

| Semi Supervised Learning(반지도 학습) | Self Supervised Learning(자기 지도 학습) |

| Transformer(트랜스포머) | Attention Mechanism(어텐션 메커니즘) |

딥러닝 Layer Level 과 Model Level

| Layer Level | Model Level |

|

|

Manifold Learning and Representation Learning(매니폴드 학습과 표현 학습)

Manifold Learning(매니폴드 학습)

고차원 데이터가 있을 때 샘플들을 잘 아우르는 부분적인 공간이 있을 것이라는 가정에서 학습을 진행하는 방법입니다.

이렇게 찾은 매니폴드는 데이터의 차원을 축소시킬 수도 있고 데이터를 더 잘 표현할 수 있게 됩니다.

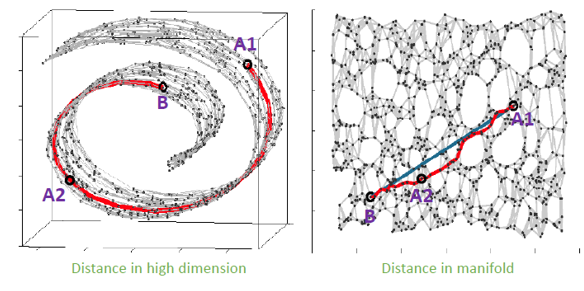

왼쪽 그림처럼 데이터가 있다고 가정해보면 데이터를 분류할 때 유클리드 거리를 바로 사용하는 것은 비합리적입니다.이때는 데이터를 펴서 분리하는 것이 더 합리적으로 생각할 수 있습니다.

우리가 잘 알지 못하는 데이터의 공간 자체를 이해해나가며 더 잘 표현하는 공간으로 변환하는 것입니다. 매니폴드 학습을 진행하면 학습된 모델의 latent vector는 차원이 달라지게 됩니다.

매니폴드 효과

데이터를 잘 나타낼 수 있는 매니폴드를 찾게 된다면 Generative Model에서 feature들을 조금씩 변형시켜가며 더 realistic한 feature를 찾아나갈 수 있습니다. 이는 데이터를 잘 표현할 수 있는 Feature space를 알고 있는 상태에서 매니폴드 좌표를 변경해가면서 데이터를 유의미하게 조금씩 변화시킬 수 있기 때문입니다. 또한, input data를 더 잘 이해할 수 있는데 dominant feature가 유사한 sample들을 알 수 있기 때문입니다.

매니폴드 방법

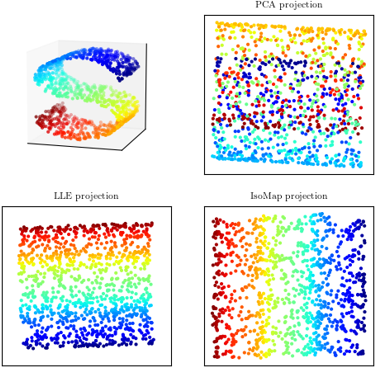

매니폴드 학습을 하기 위해서는 차원 축소 방법이 필요합니다. 차원 축소 방법에는 크게 선형과 비선형으로 구분할 수 있습니다.

| 선형 | 비선형 |

|

|

선형

Principal Component Analysis (PCA)는 데이터를 투영시켰을 때 분산을 가장 크게 만드는 벡터를 찾는 방식입니다. 이를 위해 공분산 행렬과 특이값 분해(SVD)를 사용합니다.

Linear Discriminant Analysis (LDA)는 선형판별분석이라 부르며 다른 클래스에 속한 데이터를 선형 분류 가능하도록 데이터 포인트를 투영시키는 알고리즘입니다. 데이터를 투영시켰을 때, 클래스간 거리를 최대가 될 수 있게 평균거리 합을 최대로 만드는 조건과 클래스 내 데이터 포인트의 분산을 최소로 만드는 조건을 갖춘 벡터를 찾습니다

비선형

Auto Encoder는 데이터를 잘 표현할 수 있는 잠재 공간(latent space)를 찾아 축소하는 방법입니다. 데이터를 잠재 공간으로 압축하는 encoder와, 잠재공간을 이용해 원래 데이터로 복원시키는 decoder를 사용합니다.

Representation Learning(표현 학습)

머신러닝과 딥러닝의 핵심 문제는 '의미 있는 데이터로의 변환'입니다. 즉, 입력 데이터를 기반으로 기대치(예상치, 예상 출력)에 근접하게 만드는 유용한 표현 학습이 중요합니다.

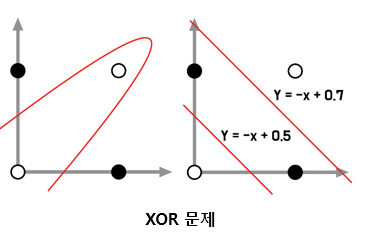

선형 모델의 한계 _ XOR 문제

데이터가 선형 관계가 아닐 경우 데이터를 구분 지을 수 없다는 한계가 있습니다. 이것이 퍼셉트론(Perceptron)이 제시된 배경이기도 합니다.

어떻게 표현하느냐에 따라 XOR 문제도 선형적으로 해결할 수 있다는 것이 표현 학습의 개념입니다.

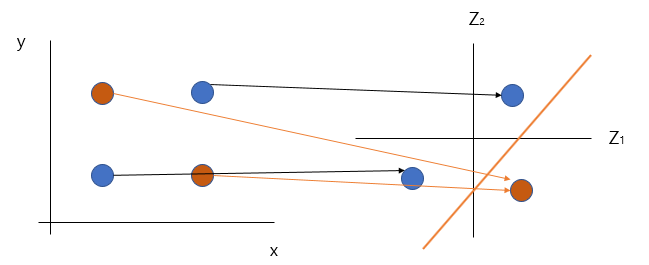

x와 y로만 표현된 좌표계에서는 선형으로 해결안되는 문제가 z축을 넣으면 선형적으로 해결 할 수 있습니다.

이처럼 표현 학습은 복잡한 데이터 공간을 선형 분류를 할 정도로 단순화해 표현하기 때문에 네트워크가 높은 성능을 낸다는 이론입니다.

'스터디' 카테고리의 다른 글

| [AI] Deep Learning 딥러닝 기본 이해_One-Shot / Few-Shot / Zero-Shot Learning (0) | 2023.06.15 |

|---|---|

| [AI] Deep Learning 딥러닝 기본 이해_전이 학습과 메타 학습 (0) | 2023.06.15 |

| [ Python ] Ubuntu22.04에서 Python3.10에서 가상 환경 설정하기 (0) | 2023.06.02 |

| WSL2(Windows Subsystem for Linux 2) 설치하기 (0) | 2023.06.02 |

| [Tableau] Tableau를 활용한 퍼스널 브랜딩_3편 (0) | 2023.03.14 |

댓글