Deep Learning 딥러닝 기본 이해

| Layer Level | Model Level |

| Manifold Learning(매니폴드 학습) | Representation Learning(표현 학습) |

| Transfer Learning(전이 학습) | Meta Learning(메타 학습) |

| Semi Supervised Learning(반지도 학습) | Self Supervised Learning(자기 지도 학습) |

| Transformer(트랜스포머) | Attention Mechanism(어텐션 메커니즘) |

Transfer Learning vs Meta Learning(전이 학습과 메타 학습)

Transfer Learning(전이 학습)

주어진 학습 데이터는 적은데 모델의 정확도와 학습 속도를 높이고 싶을 때 사용하는 학습 방법입니다. 학습하려는 데이터와 유사한 데이터가 많을 때, 혹은 유사한 데이터로 학습한 모델이 이미 존재할 때 이를 이용하는 방식입니다.

전이 학습 시나리오

전이 학습을 고려할만한 시나리오를 보기 위해서는 2가지 측면에서 바라보면 좋습니다. 첫 번째는 데이터 유사성 측면에서 바라보고 그다음은 과제 측면에서 바라보고 전이 학습을 활용할지 정하면 됩니다.

전이 학습을 사용하는 이유

1. 빠른 학습

이미 입력되는 데이터에 대해 특징을 효율적으로 추출하기 때문에, 학습할 데이터에 대해 특징을 추출하기 위한 학습을 별도로 하지 않아도 되기 때문입니다.

2. 오버피팅 예방

데이터 수가 적으면 데이터 수에 비해 모델의 가중치가 많을 수 있어 미세한 특징까지 모두 학습할 수 있습니다. 전이 학습을 이용해 마지막 레이어만 학습하게 한다면, 학습할 가중치 수가 줄어 오버피팅을 예방할 수 있습니다.

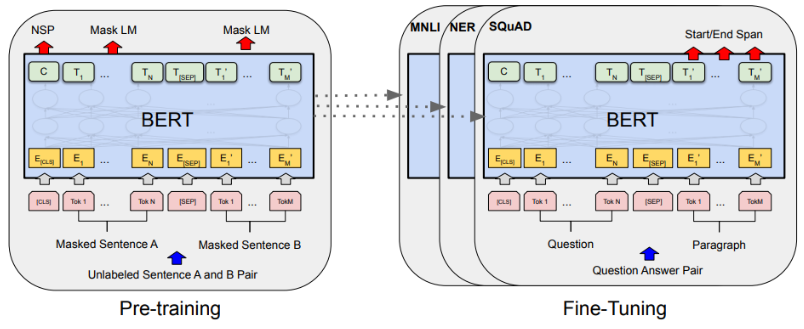

사전 학습(pre-trining)과 미세 조정(fine-tuning)

전이 학습을 하기 위해서는 이전에 학습된 모델과 앞으로 학습시킬 데이터셋이 필요합니다. 여기서 이전에 학습된 모델을 만드는 과정을 사전 학습(pre-training)이라고 하고, 사전 학습된 모델을 새로운 문제에 적용하기 위해 일부 가중치를 조절하는 학습 과정을 미세 조정(fine-tuning)이라 합니다.

전이 학습은 모델을 효율적으로 학습하기 위한 하나의 접근 방법이라면 미세 조정은 전이 학습을 하기 위한 하나의 기법이라 생각하면 됩니다.

미세 조정을 했다라고 말하기 위해서는 기존에 학습이 된 레이어에 새로 데이터를 학습시켜 파라미터를 업데이트해야 합니다. 이때 주의할 점은, 랜덤 한 초기 파라미터를 쓴다거나 가장 아래쪽의 레이어의 파라미터를 학습하게 되면 안 된다는 것입니다.

전이 학습 예시

전이 학습을 이용한 대표적인 이미지 모델로는 ResNet과 YOLO, 언어모델로는 BERT가 있습니다.

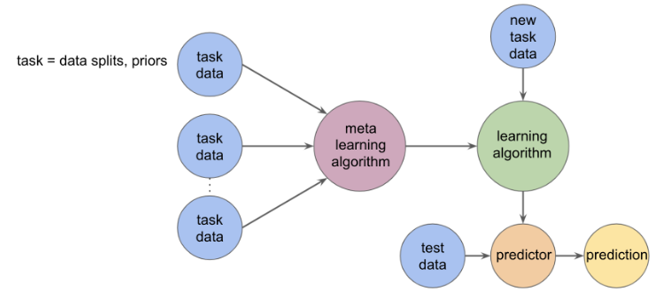

Meta Learning(메타 학습)

메타학습이란 자신이 아는 것과 모르는 것을 구별할 줄 아는 ‘메타 인지’로부터 시작한 개념으로, 적은 양의 데이터와 주어진 환경만으로 학습하고, 학습한 정보와 알고리즘을 새로운 문제에 적용하여 해결하는 학습방식을 의미합니다.

기존 머신러닝/딥러닝 한계

좋은 성능의 모형 확보를 위해서는 Large Dataset (+Large Model) 이 필수적이며, 하나의 Task 에만 적용 가능했습니다. 즉, 학습하지 못한 것은 해결 할 수 없었습니다.

그래서 나온 것이 메타 학습입니다. "적은 데이터로 학습할 수 없을까?"라는 질문을 던져 나온 해답이 기존의 경험(Trained Model)을 기반으로 몇 번의 학습(Meta Learning)만으로 구분하는 방법(Meta Model)을 배워 여러 개의 개념을 빠르게 학습할 수 있게 하면 될 거 같다 생각하여 메타 학습이 생기게 되었습니다.

메타 학습의 목표

결국에는 메타 학습의 목표는 적은 데이터로 일반화 가능하도록 학습하는 것입니다.

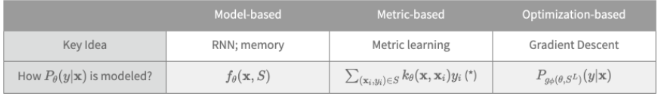

메타 학습의 학습 기법 3가지

메타러닝에서는 모든 Task 파라미터를 추정하는 것을 의미가 없고, 데이터 특성과 Task 파라미터 사이의 값을 학습하는 것이 중요합니다. 결국 데이터가 새로 들어오게 되면 데이터 특성과 Task 파라미터 사이의 값을 이용하여 추정합니다.

데이터 특성과 Task 파라미터 사이의 값을 추정하는 방법을 접근 방법에 따라 3가지로 나눌 수 있습니다.

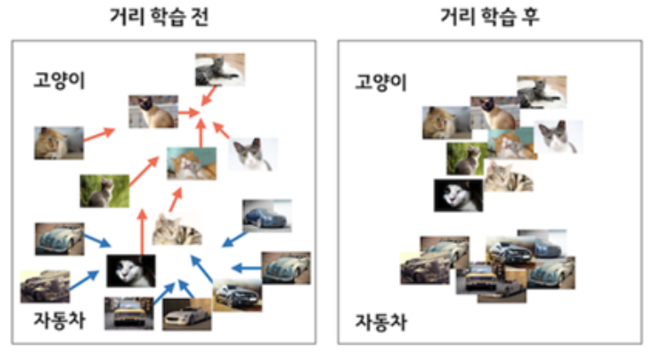

Metric-based Approach : 거리 기반 학습 기술

두 데이터 Sample 간의 유사도 정도를 기반을 이용합니다. embedding function, Distance 2가지 개념이 중요합니다.

학습 데이터를 저차원의 공간에 Mapping (임베딩)하고, 새로운 데이터가 들어오면 저 차원 공간에 임베딩하여 임베딩 공간에서 가장 가까운 클래스로 분류되는 방식입니다.

여기서 거리를 구하는 방법은 크게 3가지가 있습니다.

유클리디안 거리 (Euclidean Distance)

맨하탄 거리 (Manhattan Distance)

마할로노비스 거리 (Mahalanobis Distance)

관련 네트워크 모형에는 Siamese Networks Matching Networks Relation Networks Prototypical Networks가 있습니다.

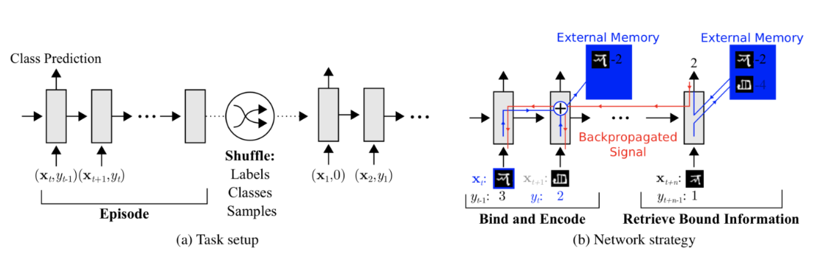

Model based apporach : 모델 기반 학습

모델 내부나 외부에 메모리를 두면서 학습 속도를 조절하는 방식입니다. 모델은 몇 번의 Training step 만으로도 파라미터 빠르게 찾는 게 가능해집니다.

관련 연구로는 Memory network, NTM, MANN가 있습니다.

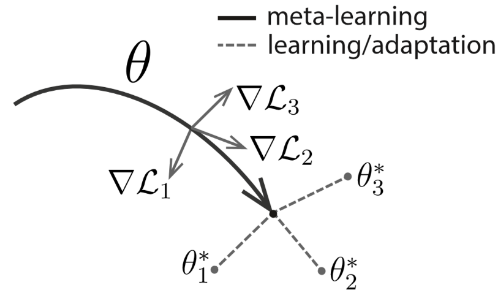

Optimization-based Approach : 최적화 기반 학습

각각의 Task의 최적 파라미터를 구할 수 있게 하는 초기 파라미터를 최적화하는 방식입니다.

관련 연구 : MAML, First order MAML, Reptile가 있습니다.

'스터디' 카테고리의 다른 글

| [AI] Deep Learning 딥러닝 기본 이해_Semi Supervised Learning and Self Supervised Learning (0) | 2023.06.15 |

|---|---|

| [AI] Deep Learning 딥러닝 기본 이해_One-Shot / Few-Shot / Zero-Shot Learning (0) | 2023.06.15 |

| [AI] Deep Learning 딥러닝 기본 이해_매니폴드 학습과 표현 학습 (0) | 2023.06.15 |

| [ Python ] Ubuntu22.04에서 Python3.10에서 가상 환경 설정하기 (0) | 2023.06.02 |

| WSL2(Windows Subsystem for Linux 2) 설치하기 (0) | 2023.06.02 |

댓글