Deep Learning 딥러닝 기본 이해

| Layer Level | Model Level |

| Manifold Learning(매니폴드 학습) | Representation Learning(표현 학습) |

| Transfer Learning(전이 학습) | Meta Learning(메타 학습) |

| Semi Supervised Learning(반지도 학습) | Self Supervised Learning(자기 지도 학습) |

| Transformer(트랜스포머) | Attention Mechanism(어텐션 메커니즘) |

BERT(Bidirectional Encoder Representation Transformer)

Transformer architecture을 중점적으로 사용한 BERT는 Language Representation을 해결하기 위해 고안되었으며, 양방향성을 포함하여 문맥을 더욱 자연스럽게 파악할 수 있도록 구조화되었습니다.

활용할 수 있는 Task

질문 및 답변, 기계번역, 문장 주제 찾기 또는 분류하기를 BERT를 통해 할 수 있습니다.

학습 과정

BERT는 디코더를 사용하지 않고, 두 가지 대표적인 학습 방법으로 인코더를 학습시킨 후에 특정 Task의 미세조정(fine-tuning)을 활용하여 결과물을 얻는 방법으로 사용합니다.

GPT와 비교하자면 GPT는 디코더만 사용하여 Text Generation 문제를 해결하였습니다.

Input Representation

기존 transformer의 input 구조를 사용하면서 추가로 변형하여 사용했습니다. BERT는 세 가지 임베딩(Token, Segment, Position)을 사용해서 문장을 표현합니다.

Pre-training

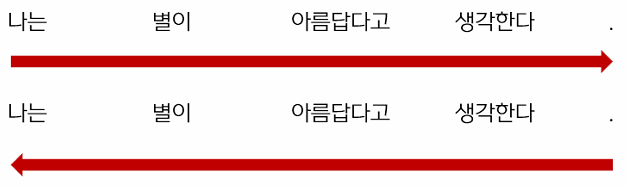

Masked Language Model

문장에서 단어 중의 일부를 [Mask] 토큰으로 바꾼 뒤, 가려진 단어를 예측하도록 학습하는 것을 말합니다.

예를 들면 아래와 같습니다.

나는 별이 아름답다고 생각한다 -> 나는 별이 [Mask] 생각한다.

나는 별이 아름답다고 생각한다 -> 나는 별이 흐리다고 생각한다.

나는 별이 아름답다고 생각한다 -> 나는 별이 아름답다고 생각한다.

Next Sentence Model

두 문장 사이의 관계를 학습하기 위해 연결된 문자이 올바르게 연결되었는지를 예측하도록 학습하는 것을 말합니다.

문장 A와 B를 이어 붙이는데, B는 50% 확률로 관련 있는 문장(Is Next label) 또는 관련 없는 문장(Not Next label)을 사용하는 것과 같습니다.

'스터디' 카테고리의 다른 글

| [AI] Vision AI 기본 이해 (0) | 2023.06.17 |

|---|---|

| [AI] Deep Learning 딥러닝 기본 이해_Attention Mechanism (0) | 2023.06.17 |

| [AI] Deep Learning 딥러닝 기본 이해_Semi Supervised Learning and Self Supervised Learning (0) | 2023.06.15 |

| [AI] Deep Learning 딥러닝 기본 이해_One-Shot / Few-Shot / Zero-Shot Learning (0) | 2023.06.15 |

| [AI] Deep Learning 딥러닝 기본 이해_전이 학습과 메타 학습 (0) | 2023.06.15 |

댓글